Ferramenta impede a manipulação de imagens por IA

Software criado pelo MIT adiciona elementos invisíveis nas fotos, impedindo que os algoritmos de inteligência artificial consigam ler ou modificar o conteúdo delas; no futuro, esse tipo de proteção pode ser essencial para as redes sociais

Software criado pelo MIT adiciona elementos invisíveis nas fotos, impedindo que os algoritmos de inteligência artificial consigam ler ou modificar o conteúdo delas; no futuro, esse tipo de proteção pode ser essencial para as redes sociais; veja por que

A ferramenta se chama PhotoGuard e foi liberada em código aberto pelos criadores, que também publicaram um artigo científico explicando como ela funciona. O objetivo do software é impedir que imagens reais sejam alteradas com inteligência artificial – ou que a IA seja usada para gerar fotos totalmente falsas, o que deve se tornar um problema crescente no futuro.

Os algoritmos de IA que geram ou modificam imagens, como o Midjourney e o Stable Diffusion, conseguem fazer isso porque foram “treinados”: alimentados com grande quantidade de fotos e ilustrações, copiadas da internet. O PhotoGuard interfere nesse processo.

A ferramenta do MIT analisa as fotos da mesma forma que o Midjourney ou o Stable Diffusion fariam – e aí adiciona a elas sequências de dados que confundem esses algoritmos, impedindo que funcionem corretamente.

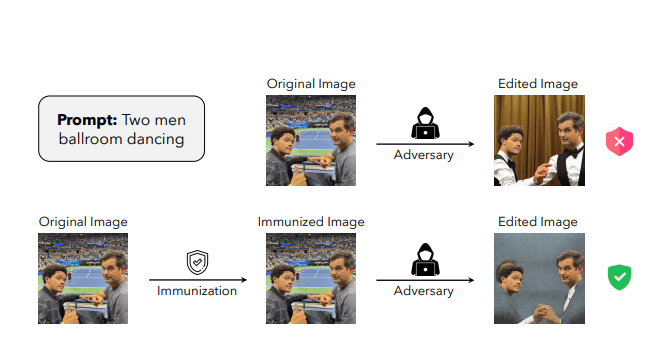

O método foi batizado de “ataque de difusão” (referência à difusão, técnica de análise e síntese visual usada pelas IAs geradoras de imagens). As alterações são imperceptíveis a olho nu – mas, segundo os criadores do PhotoGuard, suficientes para impedir que IAs alterem a foto (veja exemplo abaixo).

Veja a foto original, de dois homens numa quadra de tênis. No teste, uma IA é usada para manipular a imagem, trocando a roupa dos dois protagonistas e os inserindo em outro cenário, um salão de baile.

Porém, quando essa ordem é executada numa foto protegida pelo PhotoGuard, a IA não consegue fazer isso – e as regiões manipuladas ficam cinzas, evidenciando a fraude. O software foi testado contra a versão 1.5 do Stable Diffusion, e se mostrou eficaz.

A ideia é que o PhotoGuard seja usado para “imunizar” as fotos, protegendo-as da eventual ação de IAs, antes de publicá-las na internet.

Além de liberar o software em código aberto, para quem quiser baixá-lo, seus criadores também colocaram uma versão de demonstração online, no site Huggingface.

Ela é limitada, porque o PhotoGuard ainda é pouco otimizado: requer uma placa de vídeo bem potente, e mesmo assim roda devagar. Mas, se a equipe do MIT conseguir aperfeiçoá-lo a ponto de tornar viável seu uso cotidiano (como um plugin do Photoshop, por exemplo), ele poderá ser crucial no futuro.

Isso porque, além de impedir a adulteração das fotos, também evitaria que elas fossem usadas para “treinar” os algoritmos – que, com isso, se tornariam incapazes de gerar certas coisas.

Se você aplicasse o PhotoGuard nas suas fotos antes de publicá-las em redes sociais, por exemplo, as IAs não seriam capazes de clonar o seu rosto – algo que pode se tornar um risco real no futuro.

Nos últimos anos, os avanços da IA levantaram o receio de que ela venha a ser usada para forjar imagens e vídeos. Várias equipes de cientistas têm desenvolvido ferramentas que tentam desmascarar as fraudes.

Vêm obtendo graus variados de sucesso. Mas esse problema, detectar quando uma coisa foi gerada por IA, continua insolúvel em outro campo: o texto.

Recentemente, a OpenAI resolveu desativar sua ferramenta detectora de IA, que foi lançada em janeiro de 2023 e prometia dizer se um texto foi escrito por humanos ou por inteligência artificial. O problema é que ela era extremamente imprecisa: segundo a OpenAI, seu índice de acerto era de apenas 26%.

SEGUIR

SEGUIR

SEGUINDO

SEGUINDO

7 jogos de tabuleiro para dar de presente neste Natal

7 jogos de tabuleiro para dar de presente neste Natal Como um gene neandertal pode influenciar seus dentes

Como um gene neandertal pode influenciar seus dentes Estes são os 100 nomes de bebês mais populares de 2017

Estes são os 100 nomes de bebês mais populares de 2017 Auto da Compadecida 2: o que você precisa saber antes de assistir ao filme

Auto da Compadecida 2: o que você precisa saber antes de assistir ao filme Os gatos fazem bem para a nossa saúde? Veja o que diz a ciência

Os gatos fazem bem para a nossa saúde? Veja o que diz a ciência

![[BF2024-PRORROGAMOS] - Paywall - DESKTOP - 728x90](https://super.abril.com.br/wp-content/uploads/2024/12/BF2024-PRORROGAMOS-Paywall-DESKTOP-728x90-1.gif)

![[BF2024-PRORROGAMOS] - Paywall - MOBILE - 328x79](https://super.abril.com.br/wp-content/uploads/2024/12/BF2024-PRORROGAMOS-Paywall-MOBILE-328x79-1.gif)