Como funcionam as Inteligências Artificiais que criam imagens

Modelos de Inteligência Artificial como o Dall-E e o Midjourney fabricam imagens inéditas a partir de palavras. Entenda de que forma elas podem impactar o futuro da arte.

NNão pense em um elefante cor-de-rosa. Em vez disso, veja um: dando um google rápido, você encontra imagens editadas e desenhos do mamífero gigante em mais de cinquenta tons de rosa. Agora, um passo além: não pense em um elefante cor-de-rosa usando óculos enquanto lê o jornal em uma cafeteria. Esse você não vai achar tão fácil na ferramenta de buscas (nós tentamos).

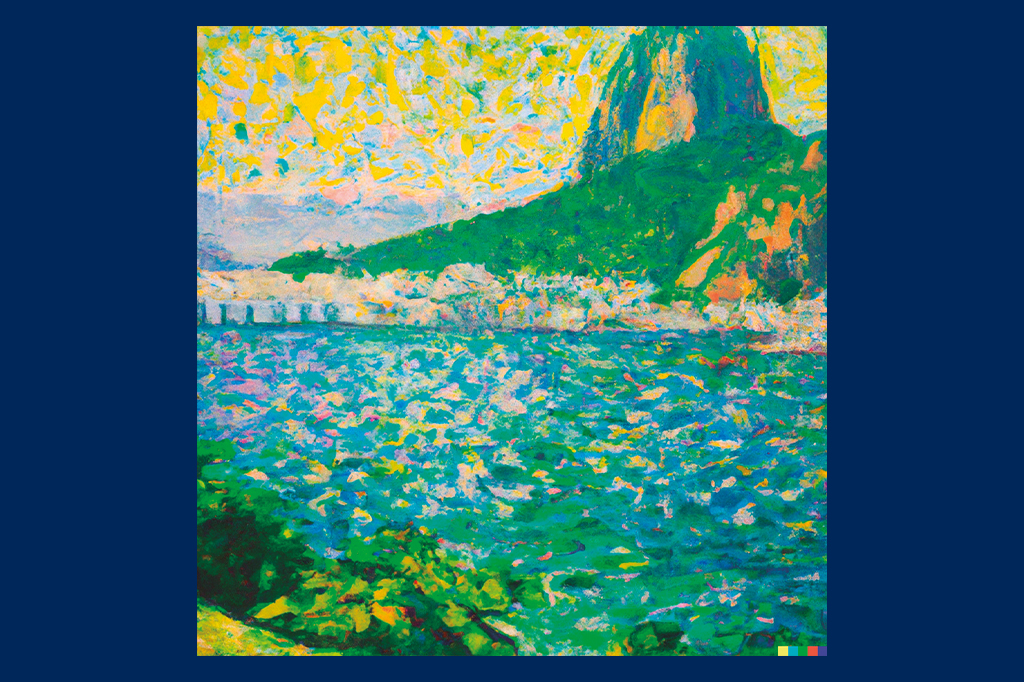

Mas existe uma outra maneira de conseguir essa cena surrealista. Faça um cadastro no site da empresa OpenAI e procure pela página do Dall-E 2. Daí, é só digitar a frase acima, em inglês, e clicar em “gerar”. Em menos de um minuto aparecerão quatro imagens inéditas, produzidas na hora. Não é montagem, tampouco há artistas humanos por trás: cada detalhe é “pintado” pelo computador. A qualidade não decepciona – é só olhar o exemplo abaixo.

O Dall-E é um programa de inteligência artificial, lançado em janeiro de 2021. O nome brinca com a sonoridade de “Dalí”, o pintor espanhol, e a grafia de “Wall-E”, o robozinho da Pixar. Em outras palavras, trata-se de uma máquina que faz arte. Basta digitar uma descrição qualquer e aguardar o resultado. Hoje, o Dall-E encontra-se em sua segunda versão, e está disponível para uso do público desde setembro de 2022.

O programa foi desenvolvido pela OpenAI, empresa fundada por um grupo de engenheiros, cientistas e investidores – dentre eles, Elon Musk (o bilionário não faz mais parte da organização, mas permanece como doador). Em pouco tempo, tornou–se uma das principais referências em pesquisa e desenvolvimento na área de Inteligência Artificial (ou IA), dando o pontapé para o surgimento das tecnologias que brincam de artista.

Após o lançamento do Dall-E, outros grupos independentes lançaram suas próprias IAs geradoras de imagem, caso do Midjourney e do Stable Diffusion. Esses dois podem ser acessados por meio de um servidor no Discord (uma plataforma de texto e áudio utilizada pela comunidade gamer). Lá, você encontra outros usuários gerando centenas de imagens a cada minuto.

A maioria das gerações tem fins recreativos (afinal, quem não gostaria de ver uma ilustração do sonho que teve na noite passada?), mas as IAs também são úteis em diferentes áreas do design. Entenda como essa tecnologia funciona – e as polêmicas que a envolve.

Por sinal: todas as imagens que você verá abaixo foram criadas com o Dall-E 2 e Midjourney.

OO que um engenheiro de dados e um professor do ensino infantil têm em comum? Ambos ensinam mini-cérebros a reconhecer padrões. Não é à toa que todas as salas de maternal são repletas de figuras: isto aqui é uma maçã, aquilo lá é uma banana. Depois de conhecer várias imagens de frutas, a criança aprende a diferenciar e nomear cada uma delas.

Uma máquina de IA também é como uma criança descobrindo o mundo. A primeira etapa é ensiná-la a reconhecer imagens. Para isso, os cientistas usam um método chamado “rede neural”, inspirado no processamento do cérebro humano. A rede possui “neurônios” artificiais interligados entre si (os “nós”). Isso permite que ela aprenda por reconhecimento de padrões, e com os próprios erros.

Imagine o Cebolinha, da Turma da Mônica, diante de um assistente de voz. Um sistema “duro”, sem rede neural, vai morrer sem obedecer quando ele pedir para tocar Racionais MC’s, pois Cebolinha dirá “Lacionais”. Um sistema de rede neural não. Grosso modo, um “neurônio” saberá que o grupo de rappers de SP tem um nome que termina com “nais”. Outro saberá que a combinação de letras “acio” também faz parte.

De cara, o input “Lacionais” não levará ao output de tocar Racionais. Dará erro. Mas, caso Cebolinha siga pedindo, a rede neural começa a trabalhar. Os nós conversam entre si e “concluem” que, na ausência de uma banda chamada “Lacionais”, o melhor é tocar Racionais mesmo. Pronto. O sistema aprendeu algo novo. Do nada. Tal qual um ser humano faz o tempo todo.

Isso não acontece em tempo real nos assistentes de voz, como a Alexa. O fato é que os desenvolvedores treinam inserindo termos falados com vários sotaques. Aí a rede neural vai pescando as diferentes formas de pronúncia e as novas versões do software vão chegando mais espertas.

Softwares de reconhecimento de imagens funcionam da mesma forma. É o caso do YOLO, usado em sistemas de carros autônomos: ele aprende a diferenciar postes de pedestres, por exemplo.

Para isso, as IAs são treinadas com bancos gigantescos de imagens, associadas a suas respectivas descrições. Ao longo dos anos 2000, quando os bancos estavam sendo criados, a tarefa de olhar e descrever cada imagem era feita manualmente, por pessoas do mundo todo que recebiam cerca de US$ 0,03 por foto.

Esse serviço ainda acontece, mas hoje há outras formas de treinar redes neurais de reconhecimento de imagem. Quando um site mostra vários quadradinhos e te pede para clicar, digamos, nos semáforos, você está associando a imagem à descrição e abastecendo o banco de dados do Google. Não à toa, o Google possui um potencial de treinamento imenso e está desenvolvendo sua própria IA de geração de imagens (chamada Imagen). Ainda não há previsão de quando ela estará disponível ao público.

Em 2015 surgiram as primeiras IAs capazes de gerar descrições sozinhas, apenas “olhando” para a imagem e comparando com as descrições que já existiam em seus bancos de dados. O que elas fazem é traduzir os pixels em uma linguagem que o computador saiba processar – tarefa chamada “embedar”, no jargão da programação. Palavras também podem ser embedadas, e daí fica fácil comparar imagens e frases. Ou criar uma a partir da outra.

Bom, se já podemos transformar imagem em texto… por que não fazer o caminho contrário? Essa foi a ideia que martelou na cabeça dos programadores da OpenAI e outras empresas pelos cinco anos seguintes. Mas antes de criar imagens inéditas a partir de texto, a tecnologia passou por uma fase intermediária: a utilização de redes neurais para estilizar imagens que já existem. Essas redes são treinadas com obras de estilo marcante (Van Gogh, por exemplo) e o transfere para uma foto comum. Em 2016, aplicativos como Prisma e DeepArt viralizaram nas redes sociais e chamaram a atenção de quem queria ver suas próprias fotos pintadas como obras de arte.

Talvez um outro aplicativo esteja mais fresco na sua memória: o Lensa. No final de 2022, é provável que você tenha cruzado com retratos dos seus amigos que pareciam ter sido pintados por artistas profissionais. Por R$ 35, o usuário faz o upload de algumas fotos no app e recebe 100 imagens do próprio rosto em diferentes estilos. O Lensa foi desenvolvido pela mesma empresa do Prisma, e é basicamente uma versão mais sofisticada de transferência de estilo.

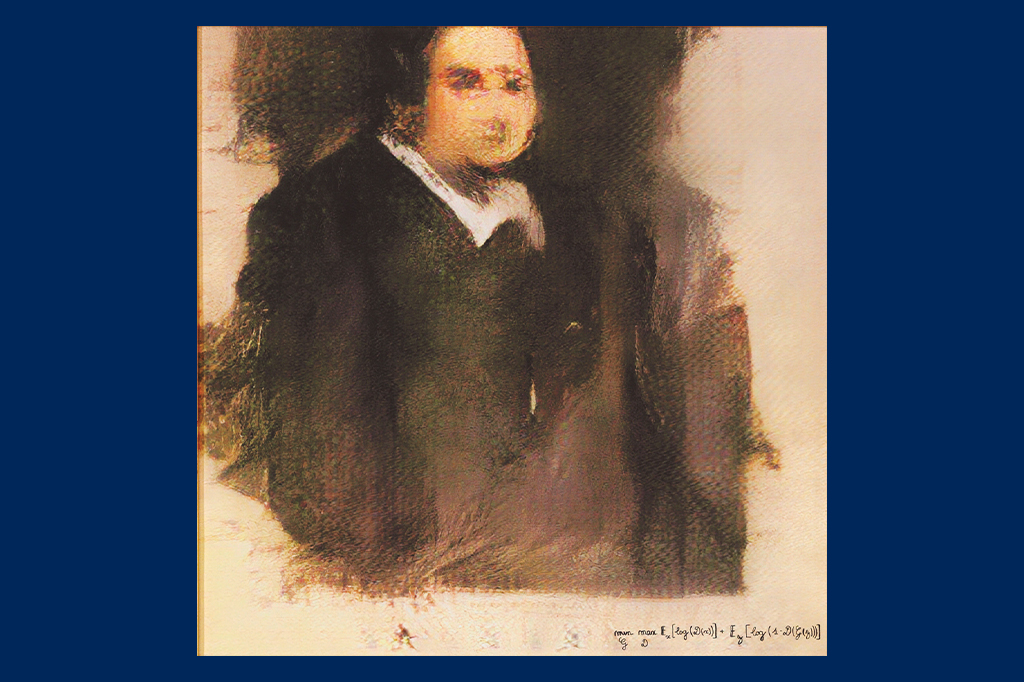

UUS$ 435 mil. É o tanto que um colecionador anônimo pagou para obter um quadro gerado por uma inteligência artificial em 2018. A casa de leilões Christie’s (a mais tradicional do mundo) anunciou a obra como a primeira imagem feita por um algoritmo a entrar em leilão. O “Retrato de Edmond Belamy” mostra um homem de terno com o rosto um pouco borrado, pintado como um quadro do século 18. Ela foi leiloada ao lado dos trabalhos de Andy Warhol e Roy Lichtenstein.

Só que a obra não impressiona quando comparada ao que viria depois. Em quatro anos, as IAs deixaram de produzir imagens borradas e passaram a ser sinônimo de ilustrações e fotos hiperdetalhadas. A questão é: como elas criam imagens inéditas do nada?

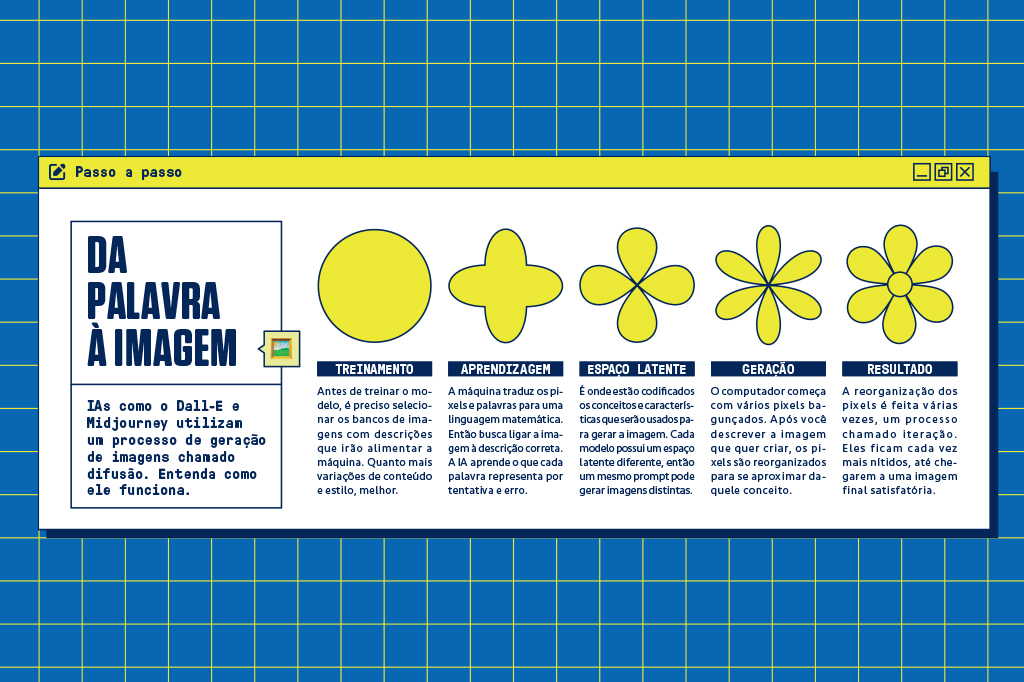

O Dall-E 2, o Midjourney e o Stable Diffusion utilizam uma técnica chamada “difusão”. Para entendê-la, vale relembrar o conceito de entropia, das aulas de física. Quando você pinga tinta em um copo de água, inicialmente o pingo ficará concentrado em meio ao líquido. Dizemos que esse é um estado “organizado”, de baixa entropia. Com o tempo, as moléculas da tinta se espalham até atingirem um aspecto homogêneo com a água, ou de alta entropia. Na natureza, é impossível reverter a entropia daquele conjunto, retornando ao estado inicial e comportado da gota.

Só que é possível fazer isso no computador. O processo de difusão é inspirado na reversão da entropia. Ele começa com uma imagem que contém vários pixels aleatórios – um estado de caos. Aí, com base em uma frase (por exemplo, “um gato feliz cozinhando um bolo”), a máquina organiza aqueles pixels em um estado menos caótico, mas que ainda não é a imagem final. Ele repete esse processo várias vezes, formando imagens cada vez mais “organizadas” até chegar, de fato, no cozinheiro felino.

Ou seja: em vez de pescar imagens prontas de gatos e de bolos em seu banco de dados, ele parte do caos total para produzir figuras completamente novas. As frases que guiam a IA até essas imagens inéditas são chamadas “prompts”.

Pegue a palavra “bolo”, por exemplo. A máquina aprendeu a associar uma série de características a esse termo: ele é redondo, tem textura fofa e parece apetitoso. Essas ideias estão codificadas no “espaço latente” do modelo, e vão desde conceitos objetivos (mais ou menos redondo) até mais abstratos, como “apetitoso” (que pode remeter a uma cobertura). Como cada IA foi treinada com bancos de dados distintos, seus espaços latentes são únicos – e um mesmo prompt dá origem a imagens completamente diferentes no Dall-E 2 e no Midjourney.

Por mais fácil que seja criar imagens com essa ferramenta, fazer boas imagens não é tão simples. É preciso saber usar os prompts, como as palavras mágicas de um feitiço. Desde o lançamento dessas IAs, muitos internautas têm passado horas em busca da melhor linguagem para se comunicar com a máquina. Já descobriram que adicionar expressões como “isométrico” e “fotografia de estúdio” geram imagens mais precisas.

E alguns até encontraram uma renda aí. O site PromptBase vende não as imagens, mas os parágrafos de texto para que você gere a imagem no Dall-E 2, Midjourney ou Stable Diffusion. Como a IA sempre cria imagens inéditas, você ganha um acervo infinito de produções com o mesmo tema ou estilo. Um prompt que promete construções feitas de Lego, por exemplo, custa US$ 1,99. Veja abaixo a comparação entre um prompt amador e um “profissional”.

Se não é isso que você procura, o site ainda oferece a opção de contratar um engenheiro de prompts para traduzir a sua ideia da melhor forma para a máquina. Mas enquanto alguns aproveitam para inventar profissões, essas IAs não estariam ameaçando o emprego de artistas de carne e osso?

EEm setembro de 2022, Jason Allen foi rechaçado nas redes sociais. Ele havia acabado de vencer a competição de arte da Feira Estadual do Colorado, na categoria de fotografia manipulada digitalmente. É inegável que a obra “Teatro de Ópera Espacial” é digna de primeiro lugar. Mas há um detalhe: Allen usou a plataforma Midjourney para gerar a imagem. Ele não revela as palavras exatas que usou para criar a obra – elas são sua receita secreta.

Mesmo assim, é como entrar em uma maratona e competir com uma Ferrari: enquanto artistas passam anos aprimorando seu estilo, as máquinas entregam uma imagem deslumbrante a partir de meia-dúzia de palavras. Com o treinamento certo, essas IAs podem copiar o estilo de qualquer artista vivo hoje. Nomes de ilustradores famosos, como Greg Rutkowski e Simon Stålenhag, são usados todos os dias para gerar imagens no Stable Diffusion. Ou seja: é como se você encomendasse o trabalho deles sem pagar por isso.

Ainda não há uma legislação específica sobre o assunto. Uma IA treinada com diferentes estilos está plagiando os artistas originais? Ou isso seria o equivalente a um artista que se inspira em referências anteriores para criar um estilo próprio? Com a disseminação da tecnologia, esses debates deverão fazer parte de novas regulamentações sobre direitos autorais.

Mas não significa que as IAs não possam ajudar os artistas. “A gente pensava que outras tecnologias do passado iam roubar nosso emprego, mas elas modificaram o mercado de trabalho”, diz Luiz Zanotello, professor na Universidade das Artes de Berlim. Temia–se que a câmera fotográfica, por exemplo, acabasse com a pintura. Isso não aconteceu, e a fotografia em si desencadeou novos movimentos artísticos. “Essas ferramentas já estão sendo usadas como impulso criativo. A máquina pode nos ajudar a pensar em coisas que não imaginaríamos tão rápido.” Isso pode produzir insights para a criação de logotipos, layouts de website, design de produtos, de interiores, fachadas… é só pedir.

Depois de dias utilizando a ferramenta, descobrimos uma pequena – mas significativa – limitação da IA. A página inicial do Dall-E 2 sugere algumas cenas surrealistas para testar na ferramenta, como um astronauta andando a cavalo. Resolvemos pedir o contrário: um cavalo andando em um astronauta. Você nunca viu, mas consegue imaginar a cena; o Dall-E, não.

É exatamente a criatividade e a capacidade de abstração humana que diferencia a nossa mente de uma máquina. A automatização de alguns trabalhos, no fim das contas, pode até dar mais tempo livre para a criação de obras ainda mais originais – que não podem ser reproduzidas em código, pelo menos por enquanto.