A máquina moral

Veículos autônomos vão precisar de uma ética própria no trânsito. O problema, como prova um experimento do MIT, é que a moral humana não cabe num software.

Um trem desgovernado está prestes a atropelar cinco funcionários que consertam os trilhos de uma ferrovia. Só há uma maneira de salvar a vida deles: para isso você, leitor, precisa puxar a alavanca que faz o veículo trocar de linha, desviando do grupo. Essa ação, porém, fará a máquina passar por cima de outro operário, que está sozinho na via ao lado. Em resumo, se você não fizer nada, cinco pessoas morrem. Se agir, o resultado é uma morte e cinco vidas poupadas. O que fazer?

É possível que você já tenha ouvido falar no desafio moral acima – ou, quem sabe, tenha assistido recentemente à cena recriada na série de TV americana The Good Place. A situação hipotética ganhou fama com o nome de “dilema do bonde”, e foi proposta em 1967 pela filósofa britânica Philippa Foot. Não há resposta certa ou errada para o problema – ele serve apenas para deixar você numa saia-justa, já que ambas as alternativas estão longe do que consideraríamos uma escolha moralmente ideal.

Mais recentemente, o dilema deixou o campo teórico e ganhou uma aplicação que anda bem em voga: a tecnologia por trás da prevenção de acidentes envolvendo carros autônomos.

Motoristas orgulhosos podem nunca admitir isso, mas a verdade é que carros autônomos tendem a ser muito mais seguros que aqueles pilotados por humanos. Veículos do tipo não correm o risco de exagerar no happy hour, não se distraem checando o celular nem ficam com sono. São fiéis às leis de trânsito e, graças a seu cérebro eletrônico, podem detectar instantaneamente eventuais falhas mecânicas. Mesmo com todos esses predicados, eles ainda pecam em um quesito: não são capazes de replicar o senso de ética humano frente ao volante.

Em situações triviais de trânsito, isso não costuma ser problema. Porém, em cenários mais exóticos, um carro sem motorista pode se ver diante de um impasse que não pode ser resolvido por sua lógica de máquina – que entende apenas sim ou não, zero ou um. Pelo menos, não com o sucesso esperado.

Na teoria, um pedestre precisa atravessar na faixa e esperar o sinal abrir se quiser ter prioridade. Mas e se ele for displicente? O carro, é claro, deve tentar desviar. E se, no entanto, desviar signifique colocar outra pessoa em risco, como no dilema do bonde? A coisa fica ainda mais complicada quando adicionamos características a cada um desses pedestres. O atravessador descuidado pode ser uma mulher grávida que leva pela mão uma criança pequena. Vale acertar um casal de idosos para livrá-las de um atropelamento?

Situações tão graves não são comuns nem para humanos, é verdade. Mas elas ajudam a ilustrar o tipo de reflexão ética que o trânsito exige de um motorista – e que não vai deixar de exigir só porque o motorista é um computador.

“Carros autônomos são um caso fascinante porque precisarão agir rápido em situações extremas, e não terão tempo para perguntar aos humanos o que deve ser feito”, diz Jean-François Bonnefon, diretor de pesquisas da Escola de Economia de Toulouse, na França, e pesquisador em psicologia cognitiva aplicada a máquinas.

Já que deixar para recorrer ao intelecto humano na hora H pode ser tarde demais, por que não fazer isso de antemão – e criar um banco de referências morais que sirva para ensinar carros autônomos? Foi pensando nisso que Bonnefon e uma dupla de colegas pesquisadores do MIT MediaLab, nos EUA, criaram o experimento batizado de “A Máquina Moral”.

O projeto, que existe desde 2016, consiste em um jogo online que apresenta 13 cenários, como o dos idosos versus a grávida com a criança – dilemas morais que poderiam, eventualmente, ser encontrados por veículos autônomos. Quem participa do jogo deve apontar qual acredita ser a decisão mais correta em cada caso.

Todo julgamento se orienta a partir de nove “prioridades” principais. O carro deve sempre evitar atingir o maior número de pessoas? É melhor poupar os passageiros dentro do carro ou os pedestres? Homens ou mulheres? Velhos ou jovens, obesos ou pessoas em forma? Um cachorro ou um gato?

Da mesma maneira, quem atravessa na faixa tem preferência sobre quem a ignora? Um médico deve ser poupado se a outra opção do dilema for atingir um morador de rua? E a pergunta derradeira: seria melhor deixar o carro manter seu caminho original, doa a quem doer? Ou intervir diretamente, mudando de pista e escolhendo a quem atingir?

O jogo é um estudo que ainda está aberto ao público. As respostas dadas entre novembro de 2016 e março de 2017, no entanto, viraram um artigo científico, publicado na revista Nature no final de 2018. Foram, ao todo, 39,6 milhões de respostas, cedidas por 2,3 milhões de pessoas de 233 países e territórios diferentes.

Disponível em 10 idiomas, o jogo apresenta 13 dilemas gerados de forma aleatória para cada jogador. Existem, ao todo, 26 milhões de cenários diferentes.

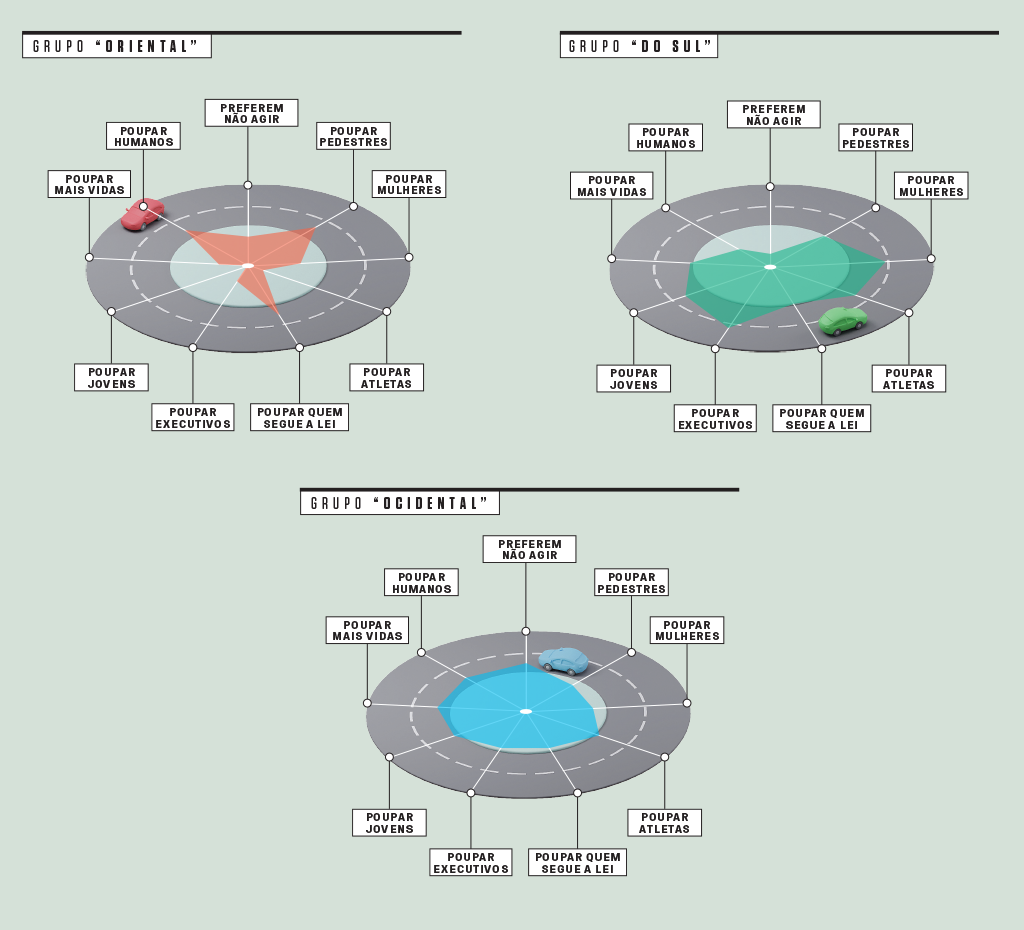

Dessa lista, os pesquisadores selecionaram os 130 países e territórios que registraram no mínimo cem participantes. Os autores criaram, então, três grupos, reunindo em cada um as nações com as preferências morais mais similares.

O grupo “Ocidental” inclui Estados Unidos, Austrália, Brasil e Europa. O “Oriental”, por sua vez, compreende a maior parte dos países asiáticos. Já no bloco “do Sul”, entram representantes da América Latina, além de França e suas antigas colônias. A lista completa de países considerados no levantamento está neste link.

A voz do povo

Além das diferenças culturais (que você vê no gráfico acima), o fator econômico mostrou ter peso importante no julgamento das pessoas. Onde a desigualdade social é mais acentuada, como na Venezuela e na Colômbia, os participantes tinham mais chances de livrar a cara de um executivo que de um morador de rua.

Seguindo a mesma linha, países com PIB per capita maior e com leis mais rígidas, como Alemanha e Japão, tendem a salvar mais quem obedece às normas de trânsito. Nações mais pobres, no entanto, seguem a lógica contrária, poupando mais os distraídos.

Em países mais religiosos, pessoas são mais inclinadas a poupar seres humanos. Nações onde mulheres têm melhores condições de vida tendem a escolher mais por elas do que por eles.

“Nossos resultados de fato mostram que as prioridades morais variam de acordo com a cultura, mas você pode enxergar isso de outra maneira: há, também, muitos pontos convergentes”, diz Bonnefon. “Por exemplo, é verdade que a preferência por salvar crianças sacrificando adultos é menos forte na Ásia e Oriente Médio – mesmo assim, qualquer país do mundo escolherá poupar os pequenos.”

Junto à preferência mundial por safar as crianças, há também outros dois consensos principais. Independentemente da idade, gênero ou nacionalidade, a maioria das pessoas concorda que é preferível atropelar animais a seres humanos (ainda que cães sejam mais poupados que criminosos) e salvar o máximo de vidas possível (livrar quatro pessoas é sempre melhor do que só duas, por exemplo).

Curiosamente, tais preferências estão de acordo com o único sistema de leis criado para regular carros autônomos que existe até hoje: uma série de 20 diretrizes elaborada pelo governo da Alemanha em 2017.

Outros pontos da lei alemã, no entanto, indicam que a vontade do povo e a de quem faz as leis pode nem sempre andar lado a lado. Isso porque uma das normas determina que “no caso de acidentes inevitáveis, qualquer distinção baseada em características pessoais (idade, gênero, condições mentais ou físicas) é estritamente proibida”. A resolução vai contra pontos que o público demonstrou achar mais ético: priorizar os mais novos e preferir cães a ladrões.

Culturas mais individualistas, como as ocidentais, têm mais chances de salvar os jovens. O grupo do Sul reúne os países que mais escolheram em favor dos animais. Japoneses são os que mais poupam pedestres, enquanto chineses defendem mais os passageiros.

Ainda que seja preciso adaptar os resultados conforme o contexto de cada país, os autores acreditam que os dados do jogo um dia possam inspirar montadoras e empresas de tecnologia. Assim, poderão orientar a criação de carros autônomos que saibam como se comportar – da maneira como esperamos – quando tudo der errado.

Foi por conta de um acidente, o primeiro envolvendo carros autônomos a causar a morte de alguém, que a Uber precisou parar e reavaliar seus testes com veículos sem motorista. Em março de 2018, a americana Elaine Herzberg empurrava sua bicicleta em uma rua da cidade de Tempe, no Arizona, quando foi atingida a 64 km/h por um Volvo modelo CX90, que estava em modo autônomo – e não conseguiu desviar dela a tempo.

Segundo dados da OMS, 1,35 milhão de pessoas morrem por acidentes com automóveis a cada ano. Mais da metade das mortes envolve pessoas que não estão nos carros – motociclistas, pedestres e ciclistas.

Onde a ideia sai dos trilhos

Apesar do potencial dos dados e do teor das conclusões sobre moralidade humana, a ideia de aplicá-las à produção dos veículos autônomos ainda não é consenso. Alguns pesquisadores não estão convencidos de que a proposta possa de fato melhorar nossa relação com carros sem motorista.

“Nós não ensinamos humanos a dirigir pedindo para que resolvam problemas que se assemelham a dilemas do tipo”, diz Julian de Freitas, que pesquisa psicologia aplicada à inteligência artificial na Universidade Harvard e coassina o artigo Duvidando dos dilemas de carros autônomos. “Isso porque planejar uma resposta para uma situação tão pouco provável, difícil de detectar ou resolver, pode distraí-los do que deveria ser o real objetivo: evitar qualquer tipo de dano”.

Focar na criação de freios melhores e sensores mais precisos, dessa forma, seria uma ideia melhor que tentar transpor nossa moralidade para veículos que funcionam por conta própria.

Há, ainda, outro problema: o quanto podemos confiar que as respostas coletadas de fato refletem a ética humana? “Quando questionamos as pessoas se elas concordavam que uma inteligência artificial escolhesse matar alguém baseada em fatores como idade, gênero e status social, menos de 20% disseram ‘sim’”, explica Freitas, em comentário sobre o artigo.

Ou seja: analisando a cena adistância, a opção por ceifar a vida de alguém parece muito mais banal do que de fato é. A moralidade desenvolvida pelos humanos é complexa demais até para nós mesmos. Que dirá para as máquinas – para quem uma criança ou um cachorro são nada além de obstáculos com tamanhos diferentes.