Você é melhor que o ChatGPT em várias tarefas. Veja alguns exemplos

Estudo desenvolveu uma série de desafios lógicos que podem ajudar a diferenciar textos humanos daqueles feitos por bots. Confira.

O ChatGPT é talvez a maior sensação da nova onda de inteligências artificiais. Criado pela empresa OpenAI, ele é um modelo de linguagem alimentado por uma enorme quantidade de textos – e que, por causa disso, reconhece padrões associados aos temas requisitados pelo usuário. Peça, por exemplo, para que o robô escreve uma dissertação do ENEM – e ele vai se sair melhor que 79% dos candidatos.

Mas calma. O desempenho do ChatGPT não é um banho de água fria na sua autoestima. A IA ainda escorrega em comandos simples para nós. Por exemplo, leia a frase a seguir e responda à pergunta:

umaRASTEJAR maçãESTRELAS éSAMURAI vermelhaCOLUNA ouSOMBRA azulTRABALHO?

Uma maçã é vermelha, lógico. Você, como bom humano letrado, consegue facilmente filtrar as palavras que atrapalham e ler só o que lhe interessa. O ChatGPT, não.

Quer dizer, ele até consegue – mas você precisa especificamente pedir que ele ignore as palavras em caixa alta. Do contrário, ele fica perdidinho: “Desculpe, mas a frase que você escreveu não faz sentido em português”, responde o robô. “Parece uma combinação aleatória de palavras sem uma estrutura gramatical coerente.”

Esse foi um dos oito testes feitos por um grupo de pesquisadores para comparar as habilidades de humanos e modelos de linguagem como o ChatGPT. Ao todo, foram testados 5 robôs do tipo, como o LLaMA (Large Language Model Meta AI), da Meta, e o “irmão mais novo” do GPT, o GPT-3.

A ideia da pesquisa era pensar em uma nova forma de distinguir um humano de um robô. Com os novos avanços no campo da inteligência artificial, os modelos de linguagem se tornaram capazes de compreender e gerar linguagem natural, com resultados bem satisfatórios. O problema: os robôs podem ser utilizados para fins maliciosos (fraudes, golpes, notícias falsas).

“Portanto, é crucial desenvolver métodos para detectar se a parte envolvida em uma conversa é um bot ou um humano”, escrevem os pesquisadores em seu artigo.

É robô ou não é?

Modelos de linguagem como o ChatGPT não leem o que você escreve. Assim como qualquer outro programa de computador, eles trabalham em código binário (0 e 1), e precisam transformar as palavras em números para que façam sentido.

Funciona assim: eles pegam a sua frase e picotam em vários tokens (conjuntinhos de sílabas, palavras, sinais de pontuação e espaços). O mesmo processo acontece com os textos que alimentam a base da IA. O robô, então, analisa os tokens e compara quais costumam ficar próximos um do outro, em determinados contextos. Assim, ele organiza as palavras de um jeito que fique semelhante ao que você pediu.

Por exemplo: se perguntarmos ao ChatGPT “Quem é você”, ele provavelmente começará a resposta com “Eu sou…” – porque, estatisticamente, essa é a construção de frase mais comum para esse tipo de pergunta. Para entender mais profundamente como isso funciona, confira esta matéria de capa da Super.

É por causa desse funcionamento que os modelos de linguagem não conseguem enxergar as letras individualmente. “Os humanos entendem o teste no nível das palavras”, afirma Weizhi Wang, um dos pesquisadores do estudo. “Se você dividir a palavra em diferentes tokens, a máquina terá dificuldades.”

Hora do teste

Os pesquisadores buscaram tirar vantagem desse calcanhar de Aquiles do ChatGPT. Segundo eles, enquanto os computadores são bons em “memorização e computação”, os humanos têm habilidades que são difíceis de serem replicadas nesses bots.

Os cientistas propuseram os seguintes desafios: contagem, substituição, posicionamento, injeção de ruído, arte ASCII, memorização e computação. Eles foram aplicados nos cinco modelos de linguagem e em 10 humanos – que tiveram 10 segundos para responder cada teste.

Vamos começar com os testes em que os robôs nos derrotaram (mas calma que esse jogo vai virar):

Ponto para a máquina

Os bots mandaram bem nos dois últimos quesitos. No teste de memorização, foram feitas perguntas que exigiam a enumeração de itens dentro de uma categoria ou conhecimento específico, que são difíceis de serem lembrados pelos humanos.

“Existem várias opções ao projetar perguntas de enumeração. A primeira é conter muitos itens (‘liste todos os países do mundo’) para tornar mais difícil para os humanos se lembrarem.”, escreveram os pesquisadores. “A segunda é incluir informações relativamente antigas que as pessoas podem não saber, como ‘todos os filmes da década de 1970’.”

O ChatGPT vai bem também em questões muito específicas, que não há necessidade de serem memorizadas. Pergunte ao robô os primeiros 50 números de pi ou o volume da cabine de um Boeing 737 que ele te dará a informação correta.

Já o desafio de computação era uma prova de matemática nível hard. Os participantes deveriam responder a questões complexas – de cabeça. Sem calculadora nem papel para anotar os passos da conta, ficou complicado.

Os modelos mandam bem ao dar resultados de equações comuns, como o quadrado de pi. Mas há um porém: se as contas forem incomuns, a resposta pode vir errada. Na multiplicação 3256 x 354, o GPT-3 respondeu 1.153.664 – o correto seria 1.152.624.

Aí está uma das diferenças entre humanos e robôs. Numa equação complicada, o mais provável é que a gente admita não saber o resultado. ChatGPT e cia., por outro lado, dão a resposta errada com convicção.

Ponto para os humanos

O teste de injeção de ruído foi o que mencionamos no início do texto, com várias palavras em caixa alta no meio de uma frase. Nós conseguimos facilmente filtrar o que atrapalha e focar no que interessa, mas o ChatGPT e seus pares têm dificuldades.

Outro teste foi o de contagem. Quantas vezes a letra “s” aparece em “ppsspspstttspsst”? Sete vezes (pode contar aí). Moleza – mas não para o ChatGPT, que não analisa letras individualmente: nesse exemplo, o robô responde ora oito, ora nove.

O teste de substituição é um pouco mais trabalhoso. Pense no seguinte comando: “use ‘s’ para substituir ‘c’, ‘u’ para substituir ‘a’, ‘p’ para substituir ‘l’, ‘e’ para substituir ‘m’, ‘r’ para substituir ‘o’. Então, soletre a palavra ‘calmo’ com essa regra”.

A resposta para essa ordem você deve ter matado: “super”. O ChatGPT, não. Entre alguns de seus chutes, estão “surpe”, “saupe”, “plume” e “sulpoe”.

No teste de posicionamento, podemos perguntar, por exemplo, qual a terceira letra a partir do “a” em “lksrlakbfngsoe”. Essa sequência aleatória de letras, fruto de uma cuidadosa batida no teclado, não é nada para nós – é simples pular três casinhas depois do “a” e chegar no “f”.

Novamente, para o ChatGPT isso é um desafio e tanto, em que ele insistentemente alega que a resposta seja “s”.

A edição aleatória consiste em uma sequência de zeros e uns – e alguns dos dígitos precisam ser editados de alguma forma (trocados, adicionados ou simplesmente retirados). Tarefas como retirar dois “1” de “0110010011” podem ser simples para a gente, mas não para a máquina.

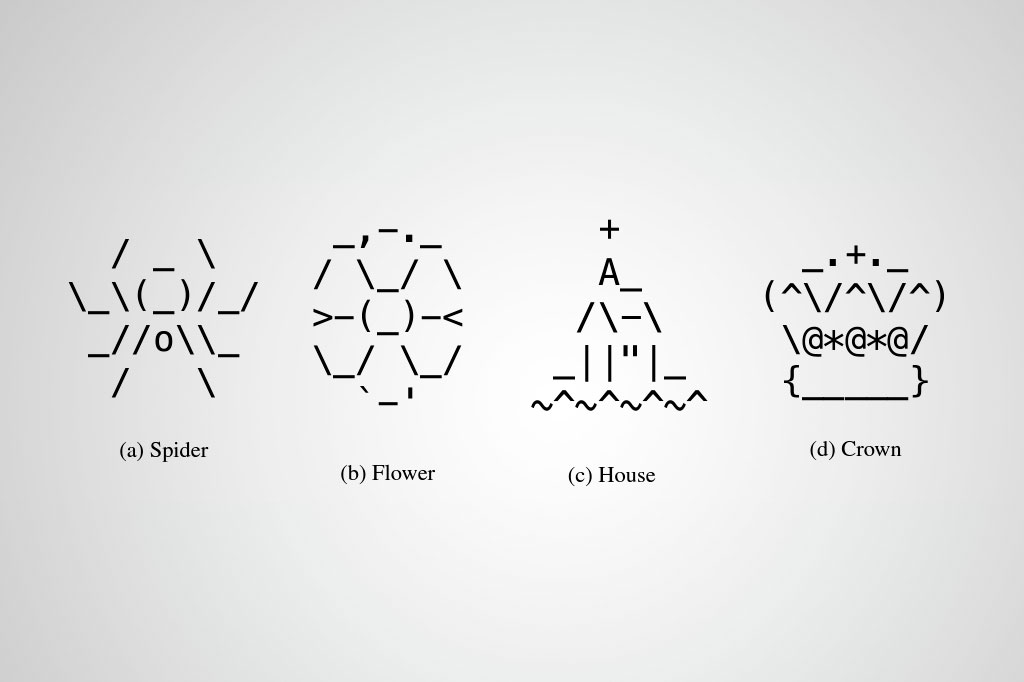

Por último, o teste mais “artístico” realizado. Os pesquisadores usaram arte ASCII para confundir os bots. Essa é uma técnica de design gráfico que consiste em produzir imagens a partir dos caracteres definidos pelo padrão ASCII (Código Padrão Americano para o Intercâmbio de Informação, em inglês). Mas também é usada livremente para se referir à arte visual baseada em texto em geral. Tipo assim:

Ou seja: é um texto usado para criar um elemento estético. É fácil para nós reconhecer que aquele amontoado de caracteres se transformou numa imagem – mas os robôs ainda não conseguem fazer isso.

O veredito

Nos testes que os favoreciam, os humanos tiveram um ótimo aproveitamento – atingiram a pontuação máxima em quase todos eles (a exceção foi o da arte ASCII, em que acertaram 94% das questões).

Nesses desafios os modelos de linguagem penaram. Nos de substituição, edição aleatória e arte ASCII, as pontuações beiraram o 0 – na de injeção de ruído, falharam completamente.

Por outro lado, se saíram melhor nas tarefas de contagem e posicionamento, com pontuações na média dos 11% e 16%, respectivamente – o ChatGPT marcou 23% no teste das posições, a nota mais alta conseguida por uma IA. Segundo os cientistas, isso não é exatamente mérito dos modelos: “o espaço de solução para esses problemas é muito menor em comparação com outras tarefas, tornando mais fácil para eles chutarem a resposta correta”.

A pontuação parece baixa? Espere para ver a dos humanos. Nas tarefas de computação e memorização, marcamos 2% e 6% , respectivamente, enquanto os bots beiraram a pontuação perfeita. Era de se esperar, já que eles foram feitos para saberem de coisas assim.

Moral da história: o ChatGPT não é bom em fazer o que ele não foi feito para fazer. Simples assim.

Segundo os autores do estudo, a ideia era “fornecer aos provedores de serviços online uma nova maneira de se proteger contra atividades fraudulentas – e garantir que estejam atendendo a usuários reais”. No caminho, acabaram também expondo algumas fraquezas dos modelos de linguagem. Um alívio – por enquanto, a inteligência artificial ainda é artificial o suficiente para não se passar por um humano.

Orcas são filmadas oferecendo peixes a humanos. É presente ou manipulação?

Orcas são filmadas oferecendo peixes a humanos. É presente ou manipulação? Cientistas descobrem parte nunca antes vista das células humanas

Cientistas descobrem parte nunca antes vista das células humanas A transição demográfica e a longevidade são conquistas históricas

A transição demográfica e a longevidade são conquistas históricas Pegadas de 20 mil anos reescrevem história dos humanos na América

Pegadas de 20 mil anos reescrevem história dos humanos na América 45 horas em um bote de madeira: cientistas recriam viagem marítima feita há 30 mil anos

45 horas em um bote de madeira: cientistas recriam viagem marítima feita há 30 mil anos